AppleがiOS 15に、子どもへの性的虐待を防ぐ新機能と、児童ポルノをiCloud 写真から検出する機能を実装することを発表しました。

Appleが子どもに対する性的虐待・児童ポルノを検出する機能を発表

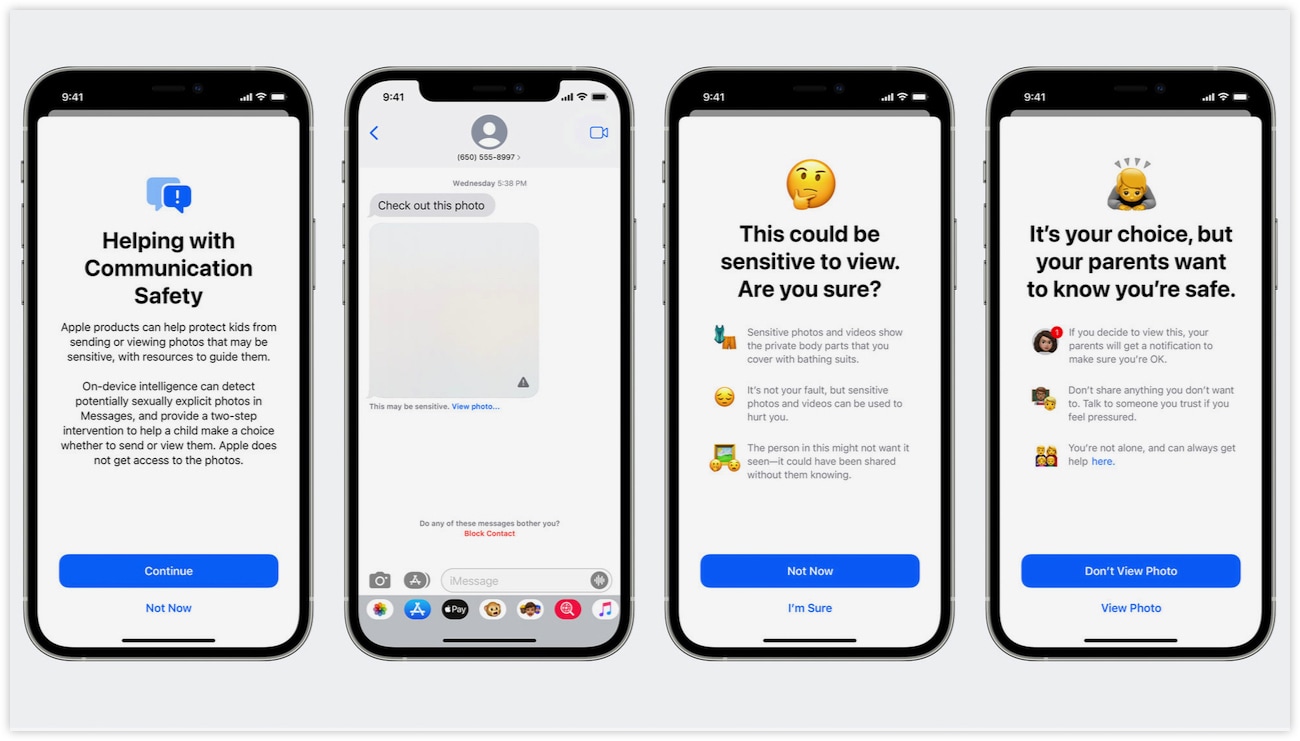

Appleは、メッセージアプリで性的な画像を送受信を検知する子ども向けの機能の実装を発表しました。この機能はファミリー共有によって保護者側からオンにすることができ、この機能で検知された画像は、自動的にぼかされ、子どもには「プライベートな体の一部が写っているかもしれません」という警告が表示されます。

また、13歳未満の子どもの場合、保護者は子どもがクリックしてぼかした写真を見た場合に、通知を受け取ることができます。子どもの警告画面には「もしあなたがこの写真を見たい場合は、両親に通知して確認してもらいます」と表示されます。

もう1つの機能が、性的虐待を行っているユーザーを自動的に検出する機能です。この機能は米国の全米行方不明・被搾取児童センター(NCMEC)が、児童への性的虐待として報告した画像(CSAM画像)を検出します。

一定のしきい値を超えた量のCSAM画像がiCloudアカウントに検出された場合、Appleは手動でそれらの画像を確認し、アカウントの停止とNCMECへの報告を行います。

Appleはこの機能が、「非常にレベルの高い精度」であることを強調しており、検出のプロセスはクラウド上ではなく、アップロード前にユーザー自身のデバイスで行われると説明しています。この機能はiCloud 写真機能がオンになっている場合のみ有効になります。

しかし、セキュリティ研究者はこれらに対し、プライバシーの侵害につながる可能性がある、と指摘しています。

Appleに詳しい海外メディアMacRumorsは、ジョンズ・ホプキンス大学のセキュリティ研究者であるマシュー・グリーン氏が、CSAM画像のスキャンは「本当に悪いアイデア」であると指摘したことを取り上げています。

グリーン氏は数多くの懸念を自身のTwitterの中で示し、Appleがこの機能を実装したことにより「政府はそれをすべての人に要求するでしょう」と述べています。

Whether they turn out to be right or wrong on that point hardly matters. This will break the dam — governments will demand it from everyone.

And by the time we find out it was a mistake, it will be way too late.

— Matthew Green (@matthew_d_green) August 5, 2021

これらの機能は現在ベータテストが行われているiOS 15に実装され、例年どおりであれば9月ごろにリリースされる予定です。

Source: AppBank

『iPhone』にiOS 15で児童ポルノ検出機能などを追加するとApple発表。プライバシーの問題につながるとセキュリティ研究者が懸念